Scienziati e ricercatori apprezzano sempre più la fantascienza per il suo contributo all’anticipazione degli scenari futuri. Nell'ambito della sua missione di esplorare le direzioni in cui ci stanno portando i cambiamenti nella scienza e nei sistemi scientifici, il Centro per il futuro della scienza ha incontrato sei importanti autori di fantascienza per raccogliere le loro prospettive su come la scienza può affrontare le numerose sfide sociali che dovremo affrontare nei prossimi decenni. Il podcast è in collaborazione con Natura.

Nel nostro quinto episodio, Qiufan Chen si unisce a noi per discutere di azione e responsabilità sociale nella scienza come sforzo umano. Per Chen, questo vale soprattutto per l’intelligenza artificiale. Durante il podcast, ci illustra gli impatti dell'intelligenza artificiale sul futuro della ricerca scientifica e come gli sviluppi dell'intelligenza artificiale possano essere più regolamentati e quindi resi più etici.

Iscriviti e ascolta tramite la tua piattaforma preferita

Qiufan Chen

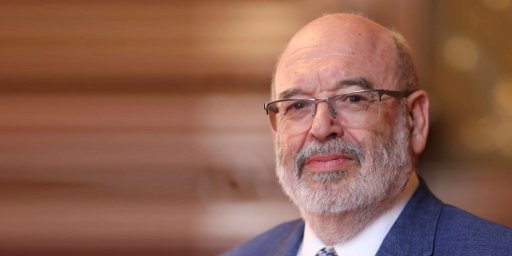

Qiufan Chen è uno scrittore cinese pluripremiato di narrativa speculativa, autore di La marea dei rifiuti e co-autore di AI 2041: Dieci visioni per il nostro futuro. È anche ricercatore presso l'Università di Yale e membro del Berggruen Institute, USA. La nostra discussione principale è incentrata sull’intelligenza artificiale e su come possiamo sfruttare la potenza di questa tecnologia evitando i pericoli che comporta.

Trascrizione

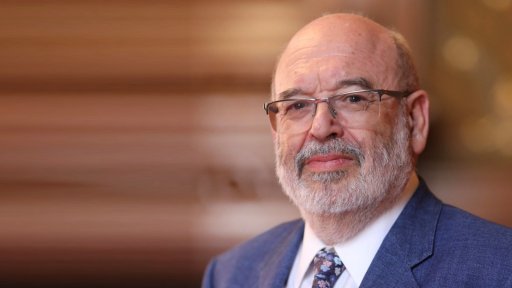

Paolo Shrivastava (00:04):

Ciao, sono Paul Shrivastava della Pennsylvania State University. E in questa serie di podcast parlo con alcuni dei principali scrittori di fantascienza di oggi. Voglio ascoltare le loro opinioni sul futuro della scienza e su come deve trasformarsi per affrontare le sfide che dovremo affrontare negli anni a venire.

Qiufan Chen (00:24):

L'intelligenza artificiale in futuro, forse potrebbe essere utilizzata per aiutarci a riflettere noi stessi come uno specchio, per farci diventare un essere umano migliore.

Paolo Shrivastava (00:33):

Oggi parlo con Qiufan Stanley Chen, uno scrittore cinese pluripremiato. Ho letto il suo romanzo, La marea dei rifiuti molti anni fa, e rimase colpito dal suo ritratto della difficile situazione dei rifiuti elettronici. Il suo libro più recente come coautore AI 2041: 10 visioni del nostro futuro, combina vividamente storie fantasiose con previsioni scientifiche. Abbiamo parlato molto dell’intelligenza artificiale e di come possiamo sfruttare la potenza di questa incredibile tecnologia, evitando alcuni dei pericoli che comporta.

Grazie mille per esserti unito a noi, Stan. Benvenuto. È sorprendente che la gamma di argomenti scientifici su cui hai padronanza sia davvero notevole. Come sei arrivato ad interessarti a questi argomenti scientifici?

Qiufan Chen (01:28):

Quindi, da fan della fantascienza, devo ammettere che ho iniziato da tutti questi Star Wars, Star Trek, Jurassic Park, film e libri classici di fantascienza, animazioni del passato. Ogni volta mi ha dato un sacco di nuove ispirazioni e idee. Quindi, sono sempre stato totalmente affascinato da tutti questi segni, dall'immaginazione del futuro, dello spazio e persino delle specie milioni di anni fa. Quindi, come li abbiamo riportati in vita.

Paolo Shrivastava (02:02):

Quindi, la scienza va avanti da molto tempo. Qual è la tua visione generale della scienza come impresa umana?

Qiufan Chen (02:13):

Per me è sicuramente un risultato enorme. E, naturalmente, ci fa vivere una condizione migliore come essere umano. E, quando guardiamo indietro alla storia, devo ammettere che ci sono molte sfide, perché mi sembra che l'agenzia non sia assolutamente nelle mani degli esseri umani. A volte ho la sensazione che forse la scienza e la tecnologia, proprio come alcune specie, come alcuni esseri biologici, abbiano un proprio scopo. Ha un proprio ciclo vitale di nascita. Vuole essere ed evolversi insieme agli esseri umani. Quindi, noi siamo come l'ospite, loro sono come il virus. Possiamo vederlo in questo modo o viceversa. Quindi, ho sempre la sensazione che ci sia un legame davvero profondo tra la scienza e gli esseri umani. Quindi, a volte ho la sensazione che tutto questo sviluppo della scienza e della tecnologia ci abbia cambiato molto, ma non sappiamo mai quale sia la direzione che abbiamo davanti.

Paolo Shrivastava (03:24):

Bene, rendiamolo più concreto e concentriamoci su ciò che è più importante in questo momento, ovvero l'intelligenza artificiale. Come possiamo garantire che lo sviluppo dell’intelligenza artificiale tenga conto della giustizia sociale e di considerazioni etiche e morali?

Qiufan Chen (03:40):

Il problema è che non abbiamo investito completamente per creare questo tipo di regolamentazione e quadro per prevenire eticamente che accada qualcosa di negativo. Penso che abbiamo bisogno di una maggiore diversità sull'intelligenza artificiale, e in particolare sul modello linguistico ampio, perché stiamo parlando specificamente di allineamento. Quindi, anche tra esseri umani di paesi, culture e lingue diverse, non avevamo questo allineamento condiviso come unico standard. Quindi, come possiamo insegnare alla macchina, all’intelligenza artificiale, ad allinearsi al sistema di valori umani o agli standard come un tutt’uno? Quindi, penso che questo sia qualcosa di molto preliminare. Ma penso che l’input chiave dovrebbe provenire non solo dalle aziende tecnologiche, dagli ingegneri, da tutte queste persone che lavorano nel settore, ma anche dal mondo interdisciplinare, come le antropologie e le psicologie, la sociologia, per esempio. Abbiamo bisogno di una prospettiva più diversificata da parte delle discipline umanistiche, perché si suppone che l’intelligenza artificiale sia costruita per le persone, per servire le persone. Ma, in questo momento, sento che il fattore umano è del tutto assente.

Paolo Shrivastava (05:11):

Quindi, secondo te, in che modo questi progressi tecnologici cambieranno il modo in cui si farà scienza in futuro?

Qiufan Chen (05:19):

Mi sembra che questo sia un cambiamento di paradigma totalmente nuovo che gli scienziati possono utilizzare con l’intelligenza artificiale per cercare nuovi modelli, prevedere la struttura delle proteine e trovare la correlazione all’interno di un’enorme quantità di dati. Penso che questo sarà qualcosa di rivoluzionario. Ma ci sono anche molte preoccupazioni all'interno di questo processo. Ad esempio, in questo momento possiamo prevedere milioni di strutture proteiche, ma il problema è: quanta percentuale di tutte queste previsioni sulla struttura proteica sono valide ed efficaci per la vera malattia e il vero corpo umano? E un'altra cosa è che tutta questa area rivoluzionata si sta concentrando sull'accumulo di un'enorme quantità di set di dati. I dati vengono raccolti da che tipo di gruppo? Che tipo di popolazione? E stanno condividendo questi dati con preavviso, per cui sono stati utilizzati tutti? E stiamo condividendo i dati tra diversi gruppi di scienziati o ricercatori? Quindi penso che si tratti sempre di come possiamo costruire questo tipo di sistema di controbilanciamento per ridurre al minimo i rischi e le sfide, e nel frattempo soddisfare realmente le richieste del mercato e ottenere i migliori benefici per le persone.

Paolo Shrivastava (06:56):

Sì, penso che costruire il sistema di controlli ed equilibri sia una parte importante dello sviluppo dell'intelligenza artificiale. Ma gli impatti ambientali dell’intelligenza artificiale stessa sono raramente menzionati nelle narrazioni scientifiche pubbliche.

Qiufan Chen (07:13):

Questo è qualcosa di molto paradossale, perché l’intelligenza artificiale richiede così tanta potenza. E ha bisogno di calcoli in tempo reale. Ha bisogno di così tanta estrazione dall'ambiente. Ma nel frattempo possiamo usarlo per rilevare l'incendio violento dal satellite. Possiamo usarlo per proteggere la biodiversità. Possiamo usarlo per trovare una nuova soluzione come l’accumulo di energia nelle batterie, nelle reti intelligenti e forse anche nella tecnologia della fusione nucleare in futuro. Quindi, se usato nel modo giusto, può sicuramente proteggerci e combattere il cambiamento climatico.

Paolo Shrivastava (08:03):

Pensi che ad un certo punto del futuro l’intelligenza artificiale capirà più di quello che gli esseri umani possono capire?

Qiufan Chen (08:13):

Quindi, quello a cui stavo pensando è un modello, un modello di grandi dimensioni oltre l'umano. Ad esempio, i dati provengono da animali, piante, funghi, persino dal micro e dall'intero ambiente. Quindi, stiamo parlando dell'intero modello terrestre. Dobbiamo distribuire questo tipo di strati di sensori in tutto il mondo. Quindi forse possiamo usare la polvere intelligente, menzionata nel romanzo di Lem L'invincibile. Quindi, stai parlando di tutto questo sciame di piccole polveri, fondamentalmente è un'intelligenza collettiva. E l'essere umano può imparare moltissimo da questo tipo di modello di grandi dimensioni, perché ci aiuta a percepire qualcosa oltre il nostro sistema sensoriale e oltre l'umano. Allora potremo essere meno incentrati sull’uomo e possiamo essere più compassionevoli verso le altre specie. E forse questa sarebbe la soluzione per combattere il cambiamento climatico, perché possiamo sentire come si sentono le altre specie e tutto questo dolore, tutta questa sofferenza, tutto questo sacrificio potrebbe essere qualcosa di tangibile e reale.

Paolo Shrivastava (09:36):

Meraviglioso. Immaginare l’intelligenza artificiale nel modello umano è in realtà un modo inferiore di pensare all’artificiale… Il modo più superiore, quello che chiami modello del mondo intero, è il modo di svilupparsi.

Qiufan Chen (09:54):

Sì. Quindi, questo mi ricorda il Buddismo, perché nel Buddismo, tutte le specie senzienti sono il più uguali possibile, e non esiste una cosa per cui gli esseri umani dovrebbero essere più importanti degli altri. Quindi penso sempre che dobbiamo trovare un modo per incorporare tutta questa filosofia e i valori del buddismo e del taoismo nella macchina.

Paolo Shrivastava (10:27):

Quindi, mi chiedo, comprendi gli elementi tecnici dell'intelligenza artificiale. L’intelligenza artificiale può essere addestrata nel buddismo e nel taoismo? Perché tutti i libri e i valori sono già codificati. È possibile trovare un'intelligenza artificiale che si addestra su di loro e crea una religione mondiale sintetica, se vuoi?

Qiufan Chen (10:50):

Sicuramente potrebbe, e potrebbe fare un lavoro migliore di qualunque prete, qualunque monaco, qualunque guru del mondo, perché è così ben informato. Ma, come praticante del Taoismo, c'è qualcosa oltre la comprensione sintetica di tutto questo, chiamiamola esperienza religiosa o spirituale, è qualcosa nel corpo. Quindi, devi fare tutti questi compiti fisici. Quindi, penso che questo sia qualcosa che ancora manca all'IA. Non aveva un corpo, non aveva il complesso sistema sensoriale, non aveva l'autocoscienza, per esempio. E penso che tutte queste parti siano ciò che rende un essere umano, umano. L'intelligenza artificiale in futuro, forse potrebbe essere utilizzata per aiutarci a riflettere noi stessi come uno specchio, per farci diventare un essere umano migliore.

Paolo Shrivastava (11:49):

Nella tua immaginazione, l'intelligenza artificiale può avere un'anima?

Qiufan Chen (11:54):

L’emergere della coscienza è fondamentalmente un mistero nella scienza in questo momento. Quindi mi sembra che ci sia sicuramente qualche connessione tra l'abilità emergente del modello linguistico di grandi dimensioni e tutti quei fenomeni di emergenza nei sistemi di complessità della fisica classica o quantistica. Quindi penso che matematicamente, forse un giorno potremo dimostrare l'esistenza della coscienza. Ma non si tratta di uno o zero status, bensì di uno spettro continuo di status. Ciò significa che forse anche una roccia, anche un albero, anche il fiume o la montagna hanno un certo livello di coscienza, ma semplicemente non lo riconosciamo perché siamo così incentrati sull'uomo. Ma è tutta una questione di calcolo. È tutta una questione di compressione spazio-temporale. È tutta una questione di conservazione delle informazioni. Quindi è tutta una questione di riduzione dell'entropia. Quindi non è una questione epistemologica, ma penso che sia una questione ontologica. Quindi si tratta di esistenza.

Paolo Shrivastava (13:14):

Grazie per aver ascoltato questo podcast del Center for Science Futures dell'International Science Council, realizzato in collaborazione con l'Arthur C. Clarke Center for Human Imagination presso l'UC San Diego. Visita futures.council.science per scoprire altri lavori del Center for Science Futures. Si concentra sulle tendenze emergenti nella scienza e nei sistemi di ricerca e fornisce opzioni e strumenti per prendere decisioni più informate.

Paul Shrivastava, professore di Management e Organizzazioni presso la Pennsylvania State University, ha ospitato la serie di podcast. È specializzato nell’implementazione degli Obiettivi di Sviluppo Sostenibile. Il podcast è realizzato anche in collaborazione con l'Arthur C. Clarke Center for Human Imagination presso l'Università della California, a San Diego.

Il progetto è stato supervisionato da Mathieu Denis e portato via DongLiu, dal Centro per il futuro della scienza, il think tank dell'ISC.

Negazione di responsabilità

Le informazioni, le opinioni e le raccomandazioni presentate in questo articolo sono quelle dei singoli contributori e non riflettono necessariamente i valori e le convinzioni dell'International Science Council.